L’etica delle macchine e la necessità del controllo umano

In questi giorni di emergenza pandemica assistiamo a un’accelerazione che in Italia forse non ci saremmo mai aspettati verso il ricorso a soluzioni tecnologiche che includono il tracciamento dei contatti e l’analisi dei dati sul nostro comportamento e i nostri spostamenti. Ormai è chiaro che l’epidemia non si combatte solo negli ospedali, ma anche nelle strade e nei centri di elaborazione dati, con le immagini delle telecamere di video sorveglianza e i movimenti delle carte di credito, con il geolocalizzatore dello smartphone e i comportamenti degli utenti online e sui social. Alla società è richiesto da un giorno all’altro di rendersi trasparente per stanare il virus. La sfida interessa naturalmente la il diritto alla privacy, ma a un livello più alto anche la tutela dei diritti umani.

Un editoriale su Science a firma di Edward Santow, commmissario del centro per i diritti umani australiano, accende i riflettori sula necessità di controllo delle decisioni prodotte dall’intelligenza artificiale in un momento in cui le soluzioni digitali ai problemi sociali vengono invocate in ogni società che sia tecnologicamente avanzata a sufficienza.

Sono diversi ormai i Paesi che consentono alle proprie forze dell’ordine di ricorrere a sistemi di riconoscimento facciale per le loro indagini. Gli algoritmi incrociano i big data e le immagini prelevati dai social media e provenienti da più di 3 miliardi di account da tutto il mondo, per individuare i sospetti. Di recente, scrive Santow, la polizia metropolitana di Londra con questa tecnologia ha individuato 104 sospetti, 102 dei quali sono risultati però errori sistematici di calcolo.

Nei Paesi occidentali per di più queste macchine capaci di apprendere sono allenate con dati che contengono un bias di campionamento, ovvero che non rappresentano fedelmente la composizione etnica della società. In altre parole sono ben addestrate a riconoscere facce di uomini bianchi ma sbagliano molto più di frequente le loro previsioni con le minoranze etniche.

Ecco spiegato perché l’impiego di sistemi di intelligenza artificiale per la gestione della sicurezza pubblica fa alzare le antenne a un esperto di diritti umani: una persona può trovarsi ad affrontare un procedimento giudiziario per l’errore di valutazione di un algoritmo.

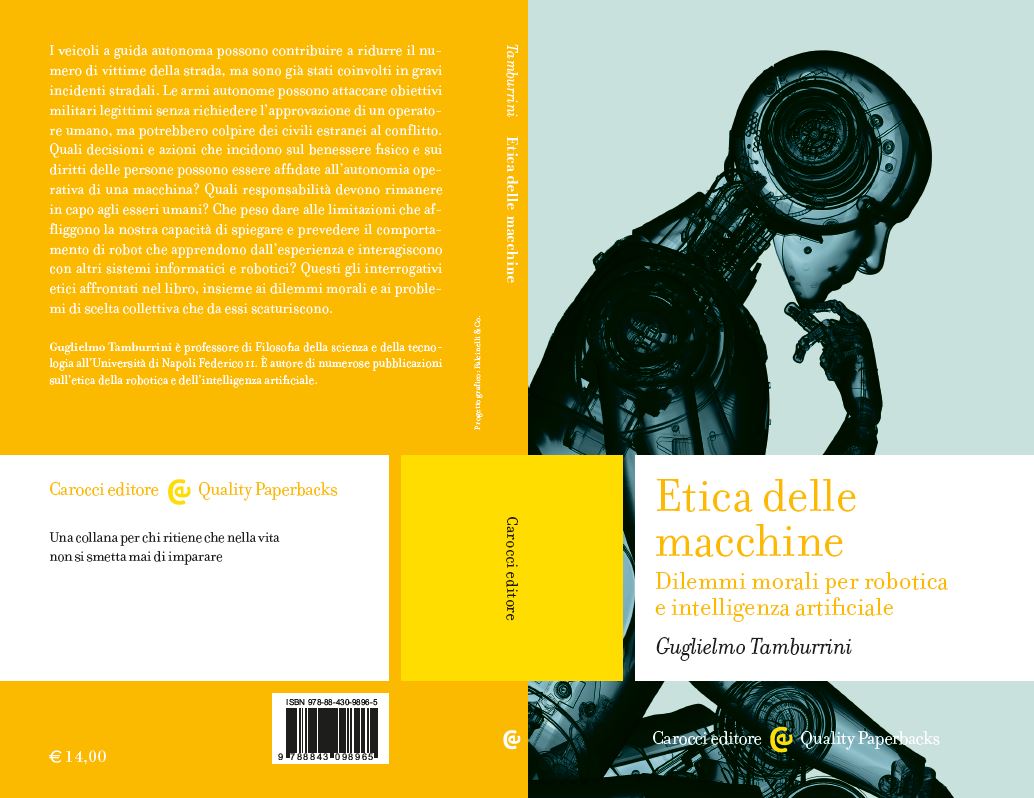

Guglielmo Tamburrini, professore di filosofia della scienza al dipartimento di ingegneria elettrica e tecnologie dell’informazione dell’università Federico II di Napoli, ha pubblicato a fine febbraio un libro per Carocci, Etica delle macchine – dilemmi morali per la robotica e l’intelligenza artificiale, che esplora i dilemmi morali che si accompagnano allo sviluppo delle nuove tecnologie intelligenti. Tra gli altri, vengono approfonditi i casi delle auto a guida autonoma e delle armi autonome, cui viene assegnata la capacità di decidere sulla vita di altre persone. Gli abbiamo chiesto se questa e altre responsabilità possano essere o meno cedute a un dispositivo, ancorché tecnologicamente avanzato.

Guarda l’intervista completa a Guglielmo Tamburrini, professore di filosofia della scienza all’università di Napoli, autore di “Etica delle macchiine”. Montaggio di Elisa Speronello

Per certi ambiti di applicazione non sono da escludere le moratorie, secondo Santow, che in Australia ne ha chiesta una per l’utilizzo del riconoscimento facciale, fintanto che non ne verrà dimostrata l’affidabilità e la sicurezza. Ad oggi però non esiste ancora un modo per rendere del tutto trasparente e comprensibile il processo decisionale dei sistemi di intelligenza artificiale. Occorre pertanto puntare su altre soluzioni, commenta Tamburrini: “in tanti ambiti le intelligenze artificiali hanno un’accuratezza e una precisione maggiore di quella degli esseri umani. Talvolta però incorrono in errori madornali in cui un essere umano non incorrerebbe mai, anche di tipo percettivo. Questi errori, per quanto rari, possono portare a un vero disastro dell’intelligenza artificiale, cosa che temono gli stessi ricercatori. Per cui è importante che ci sia sempre in situazioni moralmente sensibili un essere umano accanto o dietro la macchina. In Europa l’approfondimento del dibattito è forse più avanti che altrove. Il Gdpr (General data protection regulation) che è in vigore in Europa prevede la possibilità, da parte di qualcuno che sia stato sottoposto a una decisione automatica, di poter contestare una tale decisione. Questo è molto importante perché introduce la richiesta del controllo umano, una richiesta che si sta facendo strada in molti Paesi e per molte applicazioni: finanziarie, per le armi autonome, per decisioni che riguardano l’assunzione, la carriera, il rilascio di un prestito”.

Su queste tematiche ci aveva già messo in guardia la matematica e informatica statunitense Cathy O’neil, nel suo libro del 2016 Weapons of math destruction (Armi di distruzione matematica). Nella nostra società esistono già disuguaglianze di genere e discriminazioni nei confronti delle minoranze etniche. È necessario che i sistemi di intelligenza artificiale guidati da un algoritmo troppo rigido nell’applicare ciò che ha appreso non ne introducano di ulteriori. Occorre promuovere una discussione etica più ampia possibile e riconoscerne l’importanza, scrive Santow. Esiste un sito del governo australiano dove è possibile avanzare proposte che verranno valutate da una commissione etica in vista della redazione di un documento sull’etica dell’intelligenza artificiale previsto per fine anno.

Santow specifica che la cornice legislativa deve venire applicata in maniera più rigorosa nel contesto tecnologico per proteggere i cittadini. I sistemi di intelligenza artificiale che analizzano i dati dei comportamenti, onilne e offline, si dice rendano trasparente la cittadinanza, ne rivelano le abitudini e i desideri inconsci. Ebbene un appello deve andare nella direzione opposta, quella di rendere i sistemi di elaborazione dati trasparenti all’uomo: le decisioni delle macchine non devono e non possono venire prese in una scatola nera di circuiti e bit, inaccessibile al controllo umano. Il processo decisionale deve essere comprensibile e spiegabile, altrimenti sarebbe come affidare le nostre sorti a un impenetrabile oracolo.