Eni vs Report, il modello di gestione delle crisi nell’era digitale

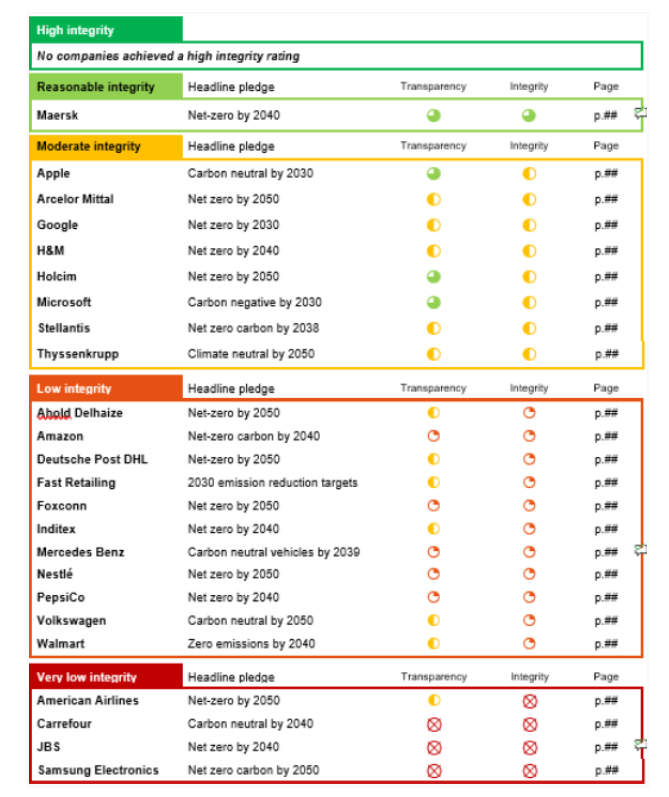

Sono passati sette anni da quella domenica sera di un freddo dicembre del 2015 in cui, per la prima volta, un’azienda rispondeva, in diretta, a una trasmissione televisiva attraverso i social. Da allora quello che è stato definito “Eni vs Report” è diventato un format utilizzato e reinterpretato da molte altre aziende (recentissimamente da Fileni vedi qui) per gestire situazioni critiche legate a una sovraesposizione mediatica televisiva. Accanto a questo la strategia di risposta è diventata oggetto di molte tesi universitarie ed è regolarmente citata in corsi e lezioni come caso di studio.

Che io debba molto professionalmente a quest’idea che proposi durante una riunione convocata per decidere come gestire le richieste della trasmissione “Report”, è un dato di fatto. Così come è un dato che nulla sarebbe stato possibile senza che l’allora direttore della comunicazione, Marco Bardazzi, la sposasse e la supportasse in pieno mettendoci direttamente la faccia, e senza che tutto il team della comunicazione di Eni la realizzasse con un durissimo lavoro (non smetterò mai di ringraziare, Andrea Andreoni, Viviana Esposti e Vincenza Gargiulo).

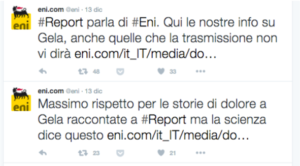

In cosa consiste il modello di risposta “Eni vs report”? Nel costruire un vero e proprio palinsesto di risposte sui social, alle singole contestazioni mosse da una trasmissione televisiva, durante la loro messa in onda. Un vero e proprio contraddittorio crossmediale, costruito sfruttando appieno quello che viene definito il “second screen” ovvero le conversazioni social che si sviluppano a commento di quel che si vede in Tv.

L’obiettivo principale è dimostrare “forza”, sia nella fondatezza e solidità dei fatti che vengono contro dimostrati e contestati, sia nella scelta stessa di rispondere, punto su punto, il che rappresenta bene la sicurezza dell’azienda e mette percettivamente in discussione la totale affidabilità di quanto sostenuto nella trasmissione stessa.

Instillare il dubbio nella audience, quindi, e affrontare la issue critica sia da un punto di vista dei contenuti ma anche e soprattutto da un punto di vista dialettico, cercando la migliore rappresentazione possibile al fine di governare la percezione reputazionale dell’azienda stessa. Partendo dall’assunto che oggi le crisi non sono governate dal sistema mediatico (leggi giornali e giornalisti) bensì da tutti gli utenti che autogenerano la narrazione grazie alle loro reazioni pubbliche e visibili sulle piattaforme social. Sono queste che diventano “notizia giornalistica”.

Tutto questo si basa ovviamente sulla certezza e veridicità delle proprie posizioni e argomentazioni. Non a caso, nel caso di Eni vs Report, l’esito dell’inchiesta giudiziaria su cui era incentrata l’inchiesta giornalistica, ha visto, recentemente, l’assoluzione con formula piena di tutti gli indagati, a partire dal Ceo di Eni sino all’azienda stessa.

Ma anche nel caso di vulnerabilità dell’azienda la logica non cambia. Anche l’ammissione dell’errore, le scuse, il racconto delle intenzioni riparatorie chiedono una precisa rappresentazione, prima ancora di una semplice trasmissione dell’informazione.

Ma andiamo con ordine

La cronaca dei fatti

La storia dello scontro “Eni vs Report” inizia con la classica richiesta d’intervista televisiva della trasmissione di giornalismo investigativo, ai tempi condotta da Milena Gabanelli, all’AD di Eni. Un’intervista che sarebbe stata registrata, senza alcuna possibilità di contraddittorio e montata dalla redazione di Report, senza alcuna possibilità di controllo, inserita in un servizio che avrebbe sostenuto il coinvolgimento dell’azienda in un caso gravissimo di corruzione internazionale. Da un punto di vista percettivo e reputazionale un vero disastro annunciato.

La trasmissione sarebbe andata in onda senza che l’azienda avesse potuto dimostrare al pubblico di avere argomenti solidi per replicare a dubbi e accuse. L’unica possibilità di replica sarebbe stata il giorno seguente, non sulla stessa piattaforma ma attraverso il classico comunicato stampa, ripreso da pochi media e con scarsa evidenza, ottenendo un impatto comunicativo e percettivo molto ma molto inferiore rispetto a quello della trasmissione stessa. Una vera e propria “esecuzione mediatica”.

Le strategie di gestione a disposizione quindi erano le solite: rifiuto dell’intervista in video, richiesta di domande scritte e produzione delle relative risposte – velocemente riassunte in diretta televisiva dalla conduttrice – comunicato stampa il giorno dopo. Non bastava, era necessario governare la percezione degli stakeholders e non subire l’onda negativa dell’inchiesta. Per ottenere questo risultato era necessario prendersi il diritto di replica e ribattere tema su tema, come fosse un vero e proprio “duello” dialettico. Ma come?

Fu proprio il concetto di conversazione a ispirare la soluzione. Report era la trasmissione giornalistica italiana con il più importante second screen: un ambiente digitale, soprattutto Twitter, dove i telespettatori commentavano i servizi della trasmissione, in tempo reale.

Conversare quindi, questa era la soluzione. Prendersi il diritto di replica, in tempo reale, attraverso il second screen di Report e contemporaneamente aprire una conversazione con gli spettatori, per portare alla loro attenzione le contro argomentazioni.

L’idea strategica era quindi governare la percezione dei telespettatori della trasmissione e degli stakeholders dell’azienda attraverso l’attivazione di una conversazione digitale con gli stessi telespettatori, contemporaneamente alla messa in onda del servizio giornalistico, in modo da poter controbattere argomento su argomento.

Un vero contradditorio crossmediale, un cross-over fra televisione e social network che di per sé, oltretutto, avrebbe ottenuto l’attenzione mediatica per la sua originalità. Oltretutto una simile reazione da parte dell’azienda avrebbe avuto anche un rilevante significato per le persone di Eni, che avrebbero visto l’azienda stessa reagire alle accuse con orgoglio e, soprattutto, con fatti e argomentazioni solide.

Se questa era la strategia, la tattica richiedeva invece uno studio attento e un dispiegamento di strumenti e risorse importante. La prima cosa che decidemmo fu di sfruttare il fattore sorpresa e per questo fu mantenuto il massimo riserbo su quanto sarebbe accaduto la domenica sera della messa in onda di report.

Fu organizzato un team operativo che, sfruttando le risposte scritte preparate per le domande che intanto la redazione di Report ci aveva inviato (approvate da tutte le funzioni aziendali e quindi pubblicabili), realizzò una serie di tweet che controbattevano ogni singola argomentazione negativa che si potesse dedurre dalle domande stesse o che rappresentassero possibili argomentazioni negative mosse all’operato dell’azienda. In buona sostanza si cercò di prevedere la struttura giornalistica dell’inchiesta, anticipandone fonti, argomenti e tesi e per ciascuna di queste vennero creati uno o più tweet da utilizzare per controbatterle.

Venne poi allestita una pagina del sito istituzionale (ancora visibile qui frutto dello splendido lavoro di Roberto Ferrari e di tutto il suo team) nella quale pubblicare l’intera versione dell’azienda, supportata da documenti e da ogni evidenza necessaria a dimostrare le tesi difensive. In ciascun tweet fu inserita la url della pagina del sito, in modo da condurvi l’attenzione degli utenti: l’obiettivo era una replica informata e supportata da documenti ed evidenze.

Infine fu studiata la struttura della trasmissione: tempi, durata dei servizi e ritmo del montaggio, alternanza fra conduzione in diretta e servizio registrato, rientri in studio, ecc. Su questa base fu studiato un vero e proprio storyboard per adattare il ritmo e la tempistica delle risposte a quelli del programma, per renderle le più efficaci possibile.

La sera della trasmissione il team si riunì in ufficio, insieme con i colleghi di altre strutture (Ufficio stampa, legali, IT), per supporto nel caso la trasmissione toccasse argomenti non previsti e si dovessero realizzare risposte all’impronta. Il team – supportato splendidamente sin dall’inizio dall’agenzia esterna, Doing – venne organizzato dedicando una persona al monitoraggio della rete (in costante collegamento con gli analisti dell’agenzia), per analizzare l’evolvere della conversazione e capire in tempo reale le eventuali criticità e identificare chi partecipasse. Un altro membro del team era dedicato a pubblicare i tweet e un altro i commenti su FB. I contenuti erano infatti stati replicati anche per Facebook.

Ogni contenuto era numerato e suddiviso per tema, arricchito da infografiche e visual. Io mi occupavo di coordinare il flusso. Man mano che la trasmissione procedeva era sufficiente chiamare un numero affinché i membri del team pubblicassero il contenuto più adatto a controbattere il tema che in quell’istante era in onda.

Il “duello” durò circo un’ora e nel mentre attirò l’attenzione dei media digitali che “coprirono” immediatamente la notizia che l’azienda stesse rispondendo a Report sui Social Network. Questo innescò un dibattito parallelo che coinvolse molti giornalisti e opinion leaders sul web e “spostò” l’attenzione dal tema della trasmissione alla risposta messa in atto dall’azienda (su questo lo studio di The Fool). La stessa cosa accadde il giorno dopo quando su tutti i media generalisti e specializzati la notizia fu la risposta digitale di Eni a Report e non il tema dell’inchiesta giornalistica (esempi Repubblica, Corriere della Sera, Wired, La Stampa, BottomUp, Corriere delle Comunicazioni, AgoràVox, Ferpi, SocialCom).

Eravamo riusciti a gestire una possibile crisi in maniera resiliente, ribaltandola a nostro favore e trasformandola in un potente driver reputazionale, interpretando al meglio la natura stessa dei social network: piattaforme che abilitano la conversazione e non strumenti editoriali. Dimostrando inoltre la natura profondamente crossmediale della comunicazione nell’era del digitale.

Non solo una modalità di risposta ma il modello di crisis management al tempo del digitale

Il modello di gestione della crisi rappresentato da “Eni vs Report” interpreta efficacemente le particolarità delle issues critiche nell’era del digitale. Il modello predigitale chiedeva una prontezza di produzione e fornitura di informazioni perché la crisi era intermediata dal sistema mediatico e l’obiettivo era, appunto, fornire tempestivamente i giusti dati e le giuste informazioni per governare la narrazione del fatto, costruita dai giornalisti. Con il digitale la narrazione non appartiene più solo ai giornalisti ma soprattutto agli utenti stessi, che l’auto generano con i loro commenti e le loro prese di posizione polarizzate. Non conta più solo cosa si dice ma come lo si dice. Conta la percezione che le audiences traggono dalla forza, la modalità, la sicurezza, la forma della risposta di un’azienda coinvolta in una crisi. Al centro del processo c’è la rappresentazione prima ancora dell’informazione.

Il modello “Eni vs Report” si fonda sulla capacità di un’azienda di controbattere, in maniera decisa, solida e argomentata non tanto e non solo alle argomentazioni ma al contesto mediatico nel quale queste vengono diffuse, a una rappresentazione, quindi. E per farlo è necessario costruire una “contro rappresentazione”, in grado di indebolire, mettere in discussione quella critica e “decentralizzare” la conversazione.

Una contro rappresentazione che necessariamente deve svilupparsi sulle piattaforme nelle quali le audiences assistono e commentano ciò che accade, utilizzando lo stesso linguaggio e gli stessi format contenutistici (video, grafiche, infografiche, foto) che sostengono la issue critica. Prevedendo e gestendo soprattutto la reazione emotiva ed emozionale delle audiences.

Perché tutto questo sia possibile è però necessario “gestire la crisi quando la crisi non c’è” ovvero operare una profonda e attenta attività di risk assestement e di risk management, prevedendo i possibili scenari, pre-organizzando le strategie di risposta e preparando sia il team che i contenuti.

Il modello di reazione “Eni vs Report” è evidente che non possa e non debba essere applicato a ogni issues ma il razionale che lo sostiene è non solo attualissimo ma è il cuore del crisis management moderno.

Al centro delle crisi oggi non c’è più l’informazione ma la rappresentazione e la capacità di governare la percezione delle azioni e delle reazioni dell’azienda agli occhi delle audiences.