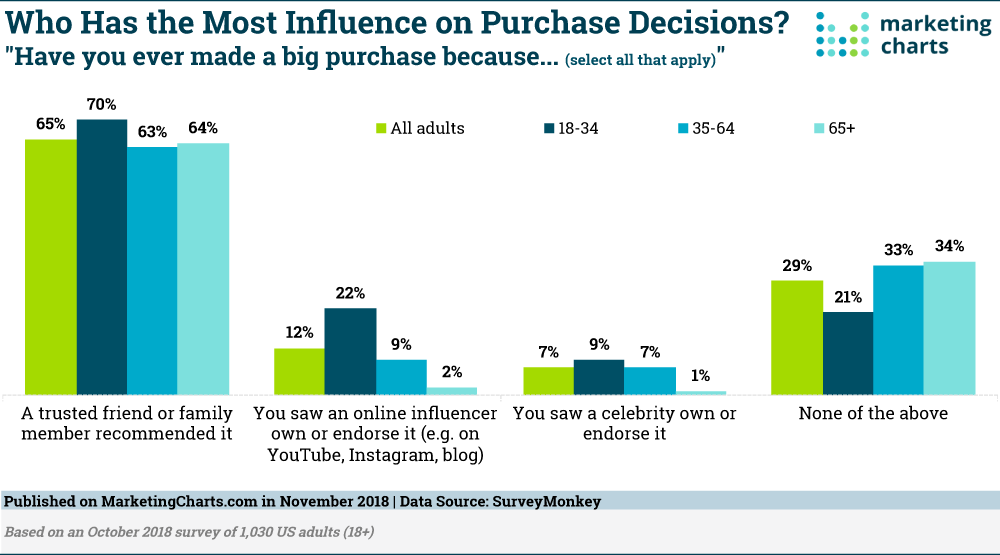

La gerarchia dell’influenza sugli acquisti: amici e famiglia > influencer online > celebrità

I contenuti di influencer marketing hanno certamente un peso sui consumatori, in particolare sui giovani, ma – pare – non lo stesso potere della raccomandazione di un amico fidato o di un familiare. Infatti, un recente studio di SurveyMonkey rileva che i consumatori statunitensi hanno più di 5 volte più probabilità di effettuare un acquisto importante a seguito una raccomandazione di un amico fidato o di un familiare (65%) rispetto al fatto di vedere un influencer online possedere o approvare il prodotto / servizio (12%).

È interessante notare, tuttavia, che gli influencer online sembrano avere più, diciamo, influenza delle “celebrità” tradizionali. Una celebrità che possiede o sostiene un prodotto, ha portato a un acquisto significativo per un numero di consumatori pari a circa la metà di quelli influenzati da un influencer online (rispettivamente il 7% e il 12%).

Ma i Millennials sono influenzati dagli influencer, giusto?

I risultati del sondaggio indicano che i giovani adulti sono più ricettivi nei confronti di influencer online – come quelli trovati su Instagram, YouTube e blog – rispetto ad altri adulti. Ad esempio, un considerevole 22% dei 18-34enni intervistati ha dichiarato di aver effettuato un acquisto significativo perché ha visto un influencer online che utilizzava o avallava l’articolo. Questo rispetto a solo il 9% dei 35-64 anni e il 2% di quelli di 65 anni e più.

Tuttavia è altresì vero che gli adulti più giovani sono anche più sensibili alle raccomandazioni di amici e parenti rispetto alle loro controparti più anziane. Sette Millennials su 10 hanno dichiarato di aver effettuato un acquisto significativo a seguito di una raccomandazione di un amico fidato o di un familiare, rispetto al 63% dei non millennials.

Ciò si aggiunge ai risultati di numerose ricerche che dimostrano come il passaparola ha un impatto più forte sui più giovani, rispetto agli anziani .

Questi risultati non sembrano valere solo negli USA; gli intervistati nel Regno Unito avevano 4 volte più probabilità di effettuare un acquisto importante a seguito di raccomandazioni di amici e familiari rispetto alle sponsorizzazioni di influencer, e in Canada probabilità 5 volte maggiori. In ogni caso, tuttavia, gli influencer online si rivelano avere comunque più efficacia delle celebrità tradizionali, proprio come negli Stati Uniti.

La TV è il medium a più alto costo

Quando si tratta di orientare acquisti importanti con campagne pubblicitarie, la TV continua a confermarsi il miglior mezzo. Un terzo degli adulti intervistati negli Stati Uniti ha dichiarato di aver fatto un acquisto significativo a causa di un annuncio visto in TV. Ciò è stato ben superiore alla percentuale di chi aveva effettuato un acquisto del genere a causa della visualizzazione di un annuncio online (17%), di una rivista (14%) o di un annuncio di Facebook (13%).

Questi risultati si collegano alla ricerca di MarketingCharts su ciò che influenza l’acquisto dei consumatori, dati che hanno confermato che le raccomandazioni di amici e parenti sono sempre davanti agli annunci TV come i principali fattori di influenza .

Nel frattempo, la ricerca SurveyMonkey rivela il dato – non sorprendente – che gli intervistati più giovani attribuiscono maggiore influenza all’acquisto agli annunci online e alle pubblicità di Facebook rispetto agli adulti più anziani, che invece hanno maggiori probabilità di effettuare un acquisto a seguito dello stimolo generato da un annuncio su una rivista.

Inaspettatamente, tuttavia, i giovani di 18-34 anni (36%) avevano più probabilità di quelli di 65 anni (28%) di attribuire un acquisto significativo a seguito della visualizzazione di un annuncio TV, questo nonostante gli adulti più grandi guardino molto più la TV tradizionale rispetto ai loro colleghi più giovani .

I risultati completi dello studio SurveyMonkey sono disponibili qui.

Informazioni sui dati: i risultati si basano su sondaggi online condotti dal 5 al 7 ottobre 2018 tra 3.053 adulti negli Stati Uniti (1.036), Regno Unito (1.010) e Canada (1.007). I dati sono stati ponderati per età, razza, sesso, istruzione e geografia.