Soldi, algoritmi e like sui social: “Così ho inventato mister Enjoy”, si vanta Mirko Scarcella, ex guru di Gianluca Vacchi, che ha lanciato molti vip in rete e sui social. Il problema non è solo che se ne vanta. Ma è la deficienza… di valori.

30 anni appena compiuti, fattura 4 milioni di euro all’anno costruendo identità digitali dal suo studio alle isole Canarie, in Spagna, e ha un tatuaggio sul petto con scritto “I am the chosen one”, io sono il prescelto. Mirko Scarcella è colui che ha decisamente contribuito a “creare” il fenomeno Gianluca Vacchi, personaggio che spopola su Instagram tra feste mondane, Rolls-Royce e balletti semi-nudo con accanto giovani ragazze e bottiglie di Dom Pérignon.

Dopo una delle ultime interviste rilasciate dall’ex guru di Vacchi in cui parla di Trump come di un idolo, abbiamo deciso di puntargli addosso i raggi x di Luca Poma, editorialista di punta di LifeGate, docente universitario, affilatissimo comunicatore d’impresa, fondatore del blog Creatori di Futuro e autore, tra i molti libri, del recente Il sex appeal dei corpi digitali, molto sul tema.

Luca, cosa pensi del fenomeno di cui parliamo?

Ci sono persone che non possono che essere definite deficienti. Lui però è benestante, visto il suo giro d’affari.

Scadiamo addirittura nell’insulto?

Ci mancherebbe, non è assolutamente nel mio stile. Mi riferivo alla parola scaturita dal participio presente del latino deficere, nel significato di mancante. In molte cose: innanzitutto il basso profilo, che in questo tipo di professione è indispensabile. Quando vengo chiamato a prestare consulenza a presidenti e Ad di aziende o a personaggi pubblici, sto sempre un passo indietro, non compaio mai, e così fanno tutti i colleghi che con passione e dedizione si dedicano a questa appassionante professione. Il “prescelto” dovrebbe essere sempre e solo il cliente.

A tuo avviso, di cos’altro “defice” Mirko Scarcella?

Non certamente di fatturato, questo bisogna ammetterlo, e riconoscerlo. Ricordo però una sua frase: “Posso realizzare grandi sogni attraverso il web in un solo giorno”. Personalmente, al di là dell’enfasi autocelebrativa e “pubblicitaria”, credo fermamente che i grandi progetti di costruzione della reputazione possano durare alla prova del tempo solo in ragione di quanto vengono costruiti su fondamenta realmente solide. E il web è uno strumento prezioso, ma non certamente l’unico, perché l’offline ha comunque un peso determinante. Ve lo vedete Gianluca Vacchi a una mostra d’arte, o che esprime un parere dal proprio punto di vista su qualche scelta di rilievo politico, o che interviene a un congresso in un’università?

Qual è allora la ricetta di Scarcella, posto che i risultati li ottiene comunque?

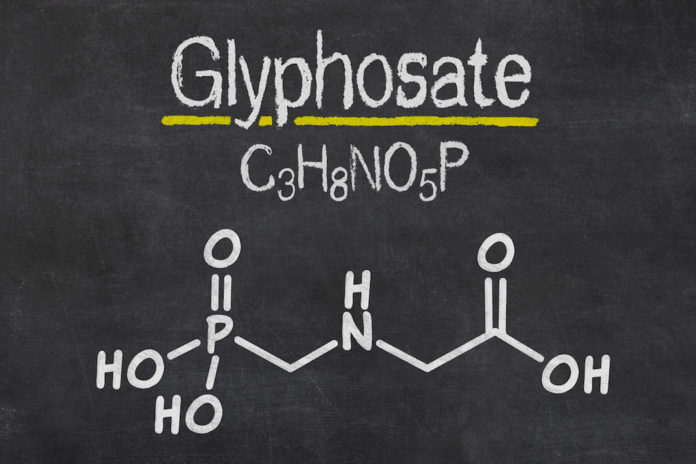

Qualcuno parla di “scorciatoie”: si sospetta l’acquisto di like in Russia per ingrossare la fanbase dei suoi clienti in modo surrettizio, l’acquisto – per sua stessa ammissione – di migliaia di domini web che fanno azioni di redirect sul profilo del cliente, canalizzando traffico per scardinare in modo artificiale i restrittivi algoritmi dei social, e – probabilmente – una gestione intelligente delle “reti di collusione”, ovvero profili social – veri o falsi è indifferente – che riuniti insieme collaborano tra loro. Una rete del genere, forte di migliaia di pagine, può facilmente e rapidamente falsare la popolarità di qualunque personaggio o contenuto, ottenendo un numero spropositato di ‘Mi piace’ e guadagnando di conseguenza molta attenzione all’interno dei social network. C’è un’interessante ricerca su queste tecniche, dell’università dell’Iowa e della Lahore University of Management Sciences, uscita proprio recentemente (la Cbs ne parla qui). Ma sicuramente sono solo affermazioni di malelingue… sarà tutta invidia.

Quindi secondo te è così che questo personaggio potrebbe essere diventato un “guru del web” come qualche collega giornalista l’ha definito?

Questo bisognerebbe chiederlo a lui. Di sicuro costruire reputazione è qualcosa di diverso che non (solo) garantire a una persona come Gianluca Vacchi milioni di follower. Il reputation management non può e non deve prescindere dalla qualità delle conversazioni, non è certo solo una questione di quantità. La nostra è una società sempre più avida di apparenze, bulimica di glamour fine a se stesso.

Il lavoro di Mirko Scarcella si può inserire in questo filone?

Probabilmente si, Gianluca Vacchi d’altra parte “è famoso per essere famoso”, non c’è alcun motivo preciso alla base della sua notorietà: ciò che ha, l’ha in buona parte ereditato. Nulla di male in questo, s’intende, ma da qui a crearne un’“icona” ce ne corre. Purtroppo in un periodo di crisi come questo, che forse solo ora stiamo molto lentamente lasciandoci alle spalle – non solo crisi economico-finanziaria, forse anche crisi morale, visti alcuni pessimi esempi che ci sono arrivati negli anni dal mondo della politica e dell’amministrazione pubblica – le persone hanno voglia sempre più di staccare la spina dal quotidiano e di rifugiarsi nel “banale che non impegna”. In questo, i balletti idioti di Vacchi in mutande sul suo yacht in qualche modo rispondono a un’esigenza diffusa, e non lo si può criminalizzare nel momento in cui lui dà a una parte degli utenti social esattamente quello che essi cercano. Ci si potrebbe interrogare se questo possa e debba essere un modello, come loro vorrebbero proporsi specie per le giovani generazioni: ma questo è un altro discorso, e ci porterebbe troppo lontano.

Tornando a chi su questa “icona” ci ha guadagnato: il modello di costruzione della reputazione digitale “un tanto al chilo” si rivela comunque vincente? Qualunque cosa, pur di raggiungere il risultato? È questo il senso della vostra professione?

A mio avviso, assolutamente no, e non solo per una ragione di “etica”. Vedi, nel lavoro del reputation manager si pone costantemente un tema, quello della distanza tra identità e immagine: quando questa distanza diverta eccessiva – push forte sull’immagine percepita, a prescindere dall’identità della persona – l’impalcatura scricchiola e rischia di crollare trascinando con se l’intero palazzo.

Non conosco personalmente Gianluca Vacchi, e non posso certamente valutare se, banalizzando, “ci fa e ci è”: però non possiamo non interrogarci su cosa rappresenta il mondo che lui porta in scena, quali valori richiama, e – infine – qual è l’obbiettivo che lui vuole raggiungere.

Se l’obiettivo è la notorietà fine a se stessa o l’accarezzamento dell’ego, la strategia di Scarcella è certamente vincente. Peccato che nessuno dei due elementi citati entri ad alcun titolo nell’equazione che determina la reputazione, che è altra cosa rispetto alla notorietà, alquanto più effimera. Sarà interessante in poche parole vedere cosa resterà di Vacchi tra cinque anni, se non saprà reinventarsi di basi ben più solide. Anche se detto tra noi il suo “posizionamento” è ormai abbastanza chiaro, e non sarà facile invertire la tendenza ed aggiungere contenuti in grado di qualificarlo e resistere all’usura del tempo.

Scarcella ha recentemente dichiarato che vorrebbe lavorare per Donald Trump, pare sia uno dei suoi idoli, insieme a Sylvester Stallone.

Non mi risulta difficile crederlo. Uno dei miei idoli invece, se posso dirlo, è José Pepe Mujica, l’ex presidente dell’Uruguay, che ha dato lezioni al mondo sulla necessità di ritrovare un modello di vita “sostenibile” e rispettoso dell’ambiente. Ha una reputazione globale semplicemente straordinaria, e neanche un follower, in quanto da ciò che mi risulta non è presente – personalmente – sulle piattaforme Social, salvo per qualche fan-page a Lui dedicata. Anche se tutto ciò per Scarcella risulterà, immagino, incomprensibile, questa è una storia di reputation pazzesca. Ecco, per lui si che mi piacerebbe lavorare: anche gratis.