Il grande piano della Cina per il dominio sul digitale

Il 28 febbraio il Comitato Centrale del Partito Comunista Cinese (PCC) e il Consiglio di Stato hanno pubblicato “Il piano generale per la costruzione della Cina digitale”.

Il programma prevede di creare un nuovo dipartimento per migliorare e regolare l’infrastruttura tecnologica del Paese. Ma anche di dare un ruolo più importante al Ministero della Scienza e della Tecnologia, integrando il digitale con altri settori industriali. E poi di risolvere i problemi che impediscono il flusso e lo scambio di dati tra diversi dipartimenti governativi; e di aumentare la domanda interna per l’industria dei semiconduttori, di cloud computing e di AI. In ultima analisi, l’obiettivo è diventare una superpotenza leader nel digitale e autosufficiente nel giro di pochi anni, capace di guidare altri Paesi del mondo verso un concetto di modernizzazione non occidentale. Cinese, per l’appunto. Ma come si è arrivati a questo piano di così ampio respiro? In realtà, è un percorso che arriva da lontano. Solo se si esamina questa “lunga marcia” si può forse comprendere meglio il significato dell’attuale strategia digitale di Pechino.

Le riforme di Deng Xiaoping e la nascita dei colossi tech cinesi

“La Cina ha una lunga storia di scienza e civiltà. Furono il decadente sistema feudale e l’aggressione delle potenze imperiali a sprofondare la Cina nell’arretratezza e nell’umiliazione dei tempi moderni. Dalla fondazione della Repubblica popolare cinese, tuttavia, scienziati e ingegneri cinesi hanno iniziato a risolvere i numerosi problemi che un tempo ostacolavano lo sviluppo della nostra società”.

È il 30 giugno 2000 e l’allora presidente cinese Jiang Zemin scrive un articolo sulla rivista Science. Per Jiang è l’occasione per fare il punto dello sviluppo scientifico del paese, un anno prima dall’ingresso della Cina nell’Organizzazione mondiale del commercio (che arriverà nel dicembre 2001). Jiang Zemin era arrivato al potere nel 1989, durante il tumultuoso periodo delle proteste e diventerà l’esecutore delle “aperture e riforme” volute da Deng Xiaoping, l’artefice dell’inserimento della Cina nel mercato globale dopo la morte di Mao Zedong (1976).

Alla morte di Mao, la situazione per la scienza e la tecnologia cinese non era delle migliori, nonostante durante il maoismo fossero stati raggiunti importanti risultati: la bomba atomica, quella termonucleare, il primo laser, il primo satellite e il primo personal computer prodotto interamente in Cina, dopo l’abbandono dei programmi di cooperazione da parte dell’Unione Sovietica a fine degli anni ‘50. Questi risultati erano arrivati nonostante alcuni progetti di Mao avessero creato morti, carestie e un dilaniamento sociale con il quale la Cina contemporanea non ha ancora fatto completamente i conti: il “Grande balzo in avanti” e la successiva “Rivoluzione culturale” finirono per complicare non poco la vita ai tanti scienziati cinesi, molti dei quali erano tornati dall’estero per prendere parte alla costruzione della “nuova Cina”.

Terminata la fase maoista e una volta conquistato il potere all’interno del Partito comunista, Deng Xiaoping aveva lanciato la “modernizzazione” del paese che prevedeva, tra le altre cose, una decentralizzazione della ricerca scientifica, non più quindi soltanto nelle mani dello Stato, e una progressiva crescita di imprese private che iniziarono a operare nel campo della tecnologia e delle telecomunicazioni. Inserire lo sviluppo tecnologico tra le priorità delle azioni del governo significava due cose: una pioggia di soldi per la ricerca e la creazione delle condizioni di mercato ottimali per le aziende cinesi.

Le “aperture e riforme” di Deng Xiaoping avevano portato alla nascita di alcune aziende cinesi che saranno destinate a dominare i propri mercati, sia internamente sia a livello internazionale: Haier era nata nel 1980 e sarebbe stata destinata a diventare una delle principali società al mondo nel settore degli elettrodomestici, Lenovo, fondata nel 1984, diventerà leader nel mercato mondiale dei personal computer (acquisendo, nel 2005, la divisione PC di IBM), Huawei fondata nel 1987 diventerà la più importante società di telecomunicazioni del pianeta. Quello degli anni ‘80 è un periodo di grande sperimentazione in Cina: il mondo della cultura vive un suo periodo d’oro, grazie all’apertura del paese e all’arrivo di tanti stranieri, quello aziendale vede nascere da lì a poco le prime joint ventures con aziende straniere. Un’occasione per confrontarsi e, in non pochi casi, per inglobare know how che permetterà poi alle aziende cinesi di muoversi con le proprie gambe. È anche un periodo bizzarro per il partito comunista: funzionari che fino a qualche anno prima si occupavano di controllare che le parole di Mao fossero recepite e ripetute un po’ da tutti, negli anni ‘80 e ‘90 si ritrovano a capo di regioni o aziende con fatturati impensabili fino a qualche anno prima. Non tutto infatti andrà per il verso giusto: la longa manus del Partito sia nelle aziende di Stato, sia nelle aziende private (la presenza di un funzionario, o ex funzionario, sarà spesso la chiave del successo anche di imprese private) porterà a fenomeni di corruzione che diventeranno endemici al sistema industriale e politico cinese. Ma nonostante questo, il Partito riesce a gettare le basi del suo futuro sviluppo digitale, cercando di piegare sempre di più le esigenze di innovazione con quelle di controllo dei processi produttivi.

La lunga marcia a tappe forzate della digitalizzazione

A un certo punto la Cina accelera: è Il 14 settembre 1987 e da Pechino parte la prima mail. Il mittente è il professor Qian Tianbai. Il testo della sua mail dice: “Attraverso la Grande Muraglia possiamo raggiungere ogni angolo del mondo”. Questo è l’evento considerato come l’inizio dell’ “era digitale” cinese. Il 20 aprile 1994 la Cina realizza la prima connessione TCP/IP completa con gli Stati Uniti. Nel 1995 il primo provider cinese InfoHighWay comincia a fornire servizi di accesso alle rete ai cittadini. Poi cominciano a nascere gli “eredi” di Haier, Lenovo e Huawei: dal 1997 al 1998 vengono fondati i portali Sina, Sohu e Netease. Un anno dopo è la volta di Alibaba, JD e dei motori di ricerca e social media Baidu e Tencent. Il 7 aprile 1998, Beijing Haixing Kaizhuo Computer Company e Shaanxi Huaxing Import and Export Company conducono la prima transazione di e-commerce in Cina utilizzando il sistema del China Commodity Exchange Center.

La Cina risente dello scoppio della bolla della “new economy” ma si riprende in fretta: nel 2003, Alibaba lancia Taobao e Alipay. Dieci anni dopo, nel 2013, il volume delle transazioni al dettaglio online supera 1,85 trilioni di RMB e la Cina diventa il più grande mercato al dettaglio online del mondo.

Questo progredire del mondo digitale non poteva che porre degli interrogativi al Partito comunista, in particolare uno: come controllare tutto questo? L’infrastruttura digitale viene quindi pensata come un sistema per ottenere alcuni risultati precisi: tenere fuori i competitor più pericolosi per le future “piattaforme” cinesi, controllare in modo assiduo il flusso dei contenuti online (attraverso il Great Firewall e la censura), assicurarsi che le aziende private perseguano obiettivi desiderati anche dal Partito comunista.Che cos’è il Great Firewall

Da metà degli anni 2000 fino al 2020 la Cina sembra il paradiso delle piattaforme, sostenute da incentivi, sgravi fiscali e poca attenzione alle condizioni di vita dei lavoratori di queste aziende. Sono le varie Alibaba e Tencent a realizzare la digitalizzazione del paese che procede a passo spedito non solo nelle grandi città: con l’arrivo degli smartphone e-commerce e social media irromperanno anche nelle zone più rurali, rendendo la quasi totalità dei cinesi connessa alla Rete.

I Big Data diventano fattore di produzione

Arrivati a questo punto, il Partito comunista decide di razionalizzare tutto questo processo: non si trattava più di gestire e bloccare informazioni e aziende in arrivo dall’Occidente, o di controllare che le aziende private “servissero il popolo”. Era arrivato il momento di una vera e propria sistematizzazione, perché nella discussione pubblica cinese entrano in ballo i Big Data, il concetto di “data driven governance”e la necessità di regolamentare il settore, per rendere chiaro, a chi per caso lo avesse dimenticato, che è il Partito a comandare.

E così arriviamo all’accelerazione degli ultimi due anni: nel 2020 viene pubblicato il documento 建设数字中国, “La costruzione della Cina digitale” (di solito citato come “Digital China”), ovvero “la strategia generale per lo sviluppo nazionale informatizzato nella nuova era. Sebbene per lo più sconosciuta in Occidente, la “Cina digitale” ha enormi implicazioni “per il percorso di sviluppo della Cina, la competizione tra grandi potenze e le norme che sosterranno il sistema internazionale per i decenni a venire”

Poi nel gennaio del 2022 è la volta del “十四五”国家信息化规划“, il 14° piano quinquennale per l’informatizzazione nazionale nel quale si specifica che “Dal 2021 al 2025, l’economia digitale cinese dovrebbe entrare in una nuova fase di sviluppo standardizzato e inclusività per tutti; nel 2035, lo sviluppo dell’economia digitale sarà entrato in una fase prospera e matura, poiché la Cina si sforza di formare un mercato dell’economia digitale unificato, equo e completo con una concorrenza ordinata diventando una forza trainante nell’economia digitale globale”.

In questo documento i Big Data sono considerati come “quinto fattore di produzione” all’interno dell’economia nazionale (insieme a lavoro, terra, capitale e tecnologia). Si tratta di uno scarto fondamentale che porterà la dirigenza a ragionare sulla “Data driven governance”, ovvero una politica guidata dai Big Data (di cui la Cina è ricchissima) con conseguente corollario di norme e regolamenti.

Contrordine compagni: inizia la stretta sulle piattaforme interne

Mentre la Cina procedeva con i suoi piani per lo sviluppo digitale, sono accadute parecchie cose che hanno finito per influenzare il dibattito cinese sui temi quali digitalizzazione, Big Data e piattaforme. Da due anni a questa parte la Cina ha portato avanti una furiosa campagna contro le piattaforme, il cui scopo non era tanto quello di distruggere le aziende, quanto “rettificarne” il comportamento. Le piattaforme cinesi erano diventate troppo potenti, troppo interessate a business e profitti privati e andavano in qualche modo richiamate all’ordine. Pechino ne ha approfittato per perimetrare la loro attività, motivando la sua scelta con la scusa che anche tra la popolazione si erano alzate voci contrarie al loro strapotere, specie per quanto riguarda la raccolta e l’utilizzo dei dati.

Nel frattempo Pechino ha cominciato e aumentato i giri della sperimentazione dello yuan digitale, con l’obiettivo di riportare all’interno dei circuiti bancari la grande massa di popolazione cinese che non ha un conto in banca e nel tentativo di entrare nel redditizio business dei pagamenti online (dominato al 90%, guarda caso, proprio da Alipay di Alibaba e WeChat di Tencent).

(Nella foto Jack Ma, il fondatore di Alibaba, che ha da poco dovuto fare un passo indietro cedendo il controllo del colosso fintech Ant Group, via Flickr)

Lo scontro con gli Usa sui chip e l’urgenza dell’autosufficienza tecnologica

Infine, lo scontro commerciale con gli Stati Uniti si è via via svelato per quello che è, ovvero uno scontro tecnologico focalizzato, almeno in questo momento, nella produzione dei chip. E così alla necessità di proseguire nella digitalizzazione e a quella di gestire nel modo migliore i dati e farne uno dei pilastri delle attività di gestione governativa, Xi Jinping ha sottolineato quanto va dicendo da tempo: che la Cina deve essere autosufficiente in tutto ciò che è digitale e tecnologia. “Dobbiamo accelerare il ritmo dell’autosufficienza tecnologica per evitare di essere strangolati da paesi stranieri. La Cina dovrebbe sforzarsi di diventare un leader globale in importanti campi scientifici e tecnologici, un pioniere in aree interdisciplinari all’avanguardia e un importante centro scientifico e hub di innovazione per il mondo”, ha detto Xi Jinping a metà febbraio durante una riunione di studio del Comitato centrale.

A margine di questo Xi Jinping ha effettuato anche un altro discorso, di fronte ai membri del Politburo, ai vertici delle forze armate, ai nuovi membri del Comitato Centrale e ai funzionari locali e ministri. A loro Xi Jinping ha fatto un discorso sulla modernizzazione particolarmente rilevante alla luce anche dello sviluppo cinese dei piani “digitali”. Non che Xi Jinping non abbia mai trattato il tema, lo aveva fatto anche prima del Ventesimo Congresso, a ottobre, ad esempio. Ma in questo intervento Xi ha specificato molte cose che ci permettono di incrociare digitalizzazione, autosufficienza e “modello cinese”.

La Via della Seta digitale: ovvero la modernizzazione cinese modello per il Sud del mondo

Xi Jinping a proposito della modernizzazione, all’interno della quale finisce anche la “digitalizzazione”, ha detto che “La modernizzazione di un paese non deve solo seguire le leggi generali della modernizzazione, ma deve anche conformarsi alla propria realtà e avere caratteristiche proprie. La modernizzazione in stile cinese non solo ha le caratteristiche comuni della modernizzazione di tutti i paesi, ma ha anche caratteristiche distintive basate sulle proprie condizioni nazionali”. E chi è interprete di queste caratteristiche? Il Partito. Quali sono le caratteristiche di questa modernizzazione? Sono cinque: la popolazione enorme, la prosperità comune, l’equilibrio “armonioso tra civiltà materiale e civiltà spirituale”, tra uomo e natura, e caratterizzata dalla pace. Questo, specifica Xi, “non è solo un riassunto teorico, ma anche un requisito pratico, e indica un’ampia strada per costruire a tutto tondo un potente paese socialista moderno e per realizzare il grande ringiovanimento (rinnovamento) della nazione cinese”. E infine: “La modernizzazione in stile cinese rompe il mito di “modernizzazione = occidentalizzazione”, mostra un’altra immagine della modernizzazione”, ampliando “le scelte di percorso per la modernizzazione dei paesi in via di sviluppo e fornisce agli esseri umani una soluzione cinese per esplorare un sistema sociale migliore. La visione unica del mondo, i valori, la storia, la civiltà, la democrazia e l’ecologia contenuti nella modernizzazione in stile cinese e la sua grande pratica sono le principali innovazioni nella teoria e nella pratica della modernizzazione mondiale. La modernizzazione in stile cinese ha dato l’esempio ai paesi in via di sviluppo di muoversi verso la modernizzazione in modo indipendente e ha fornito loro una nuova scelta”.

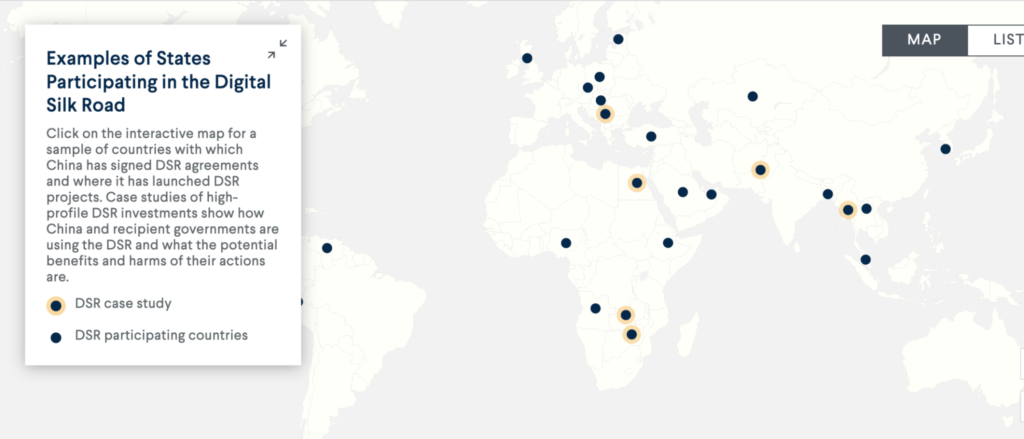

Qui abbiamo la summa del pensiero di Xi Jinping che va tenuto in considerazione anche quando si parla di “digitale”. In sostanza Xi Jinping ritiene che oggi la Cina possa essere un modello di “modernizzazione” per tanti paesi del cosiddetto Global South e anche la “Cina digitale” può esserlo, considerando lo sforzo che la Cina sta producendo in un progetto di cui non si parla granché ma che rimane fondamentale per la leadership del Partito, ovvero la “Digital Silk Road”.

(Esempi di Stati che avevano iniziative legate alla Silk Road digitale secondo una mappatura del Council on Foreign Relations)

Arriva il nuovo piano per la costruzione della Cina digitale

Il 28 febbraio la Cina ha dunque pubblicato il 数字中国建设整体布局规划, “Il piano generale per la costruzione della Cina digitale”, secondo il quale “Costruire una Cina digitale è importante per il progresso della modernizzazione cinese nell’era digitale e fornisce un solido supporto per lo sviluppo di nuovi vantaggi nella competitività del paese”.

Il piano si inserisce in un percorso che è ormai avviato da qualche anno e che si basa su alcuni assunti: secondo alcuni osservatori, il progetto è “la prima ‘grande strategia digitale’ al mondo”, dato che “Xi Jinping intende utilizzare gli effetti di trasformazione della Cina digitale per inaugurare un’era d’oro della governance (…). La realizzazione di una forma di governance più efficiente consentirà l’emergere di una nuova smart society, maggiormente in grado di provvedere al benessere, politico e materiale, dei cittadini cinesi. Altrettanto importante, questo nuovo modello di governance basata sui dati dimostrerà la superiorità e l’utilità del sistema cinese a livello globale”.

Nel Piano sono sottolineati alcuni aspetti: intanto che la Cina digitale dovrà rispondere alle esigenze di “modernizzazione in stile cinese”; poi che dovrà potenziare i seguenti settori: “la costruzione coordinata di reti 5G e reti ottiche, promuovere ulteriormente l’implementazione e l’applicazione su larga scala di IPv6, promuovere lo sviluppo completo dell’Internet of Things mobile e promuovere con forza l’applicazione su larga scala di Beidou (il sistema di posizionamento satellitare sviluppato da Pechino, ndr)”, oltre a “facilitare la circolazione delle risorse legate dati. Costruire un sistema e un meccanismo nazionale di gestione dei dati e migliorare le istituzioni generali per la gestione dei dati a tutti i livelli. Promuovere l’aggregazione e l’utilizzo di dati pubblici e creare banche dati nazionali in settori importanti come la sanità pubblica, la scienza e la tecnologia e l’istruzione. Liberare il potenziale dei dati commerciali, accelerare la creazione di un sistema di diritti di proprietà dei dati, svolgere ricerche sulla valutazione delle risorse di dati”.

I dati come risorsa semi-pubblica da sottrarre alle distorsioni del mercato

A fare da sfondo a tutto il documento ci sono due necessità della Cina di Xi: lavorare in termini di “standard” (da quelli di rete a quelli ad esempio relativi alle monete digitali) e sistematizzare la questione legata ai Big Data. A questo proposito la Cina sta lavorando anche a una regolamentazione che sia in grado di garantire sicurezza nazionale e controllo del Partito sui dati. Come ha scritto Rebecca Arcesati di Merics, “I leader cinesi vedono il controllo sui dati da parte delle burocrazie governative, delle imprese statali e delle imprese private, nonché la persistenza dei “silos di dati” come fallimenti del mercato che ostacolano lo sviluppo economico e una governance efficiente. (…) Il presupposto è che il mercato da solo non può far incontrare domanda e offerta, proteggere la sicurezza e la privacy e realizzare il potenziale dei dati come risorsa nazionale. Per il PCC, i dati sono un “fattore di produzione” insieme a terra, lavoro, capitale e tecnologia. E i leader cinesi credono che “l’allocazione dei fattori basata sul mercato” (要素市场化配置) non possa avvenire in modo sicuro ed efficiente se lasciata senza supervisione. Nell’ “economia di mercato socialista”, lo stato si considera il capo delle transazioni di dati. Come ha notato la ricercatrice tecnologica Lillian Li, designare i dati come un fattore di produzione implica la convinzione che “il valore dei dati per una nazione è sottovalutato e attualmente soggetto a distorsioni di mercato”. Gli attributi speciali dei dati come risorsa ne fanno una forma di bene semi-pubblico i cui benefici potrebbero non essere attribuiti alla società senza l’intervento del governo”.

Il nuovo assetto digitale per le sfide geopolitiche

Ma al di là di quelle che saranno poi le applicazioni interne cinesi, complice anche uno spostamento dell’attenzione del Partito su aziende più coinvolte nella supply chain tecnologica rispetto al passato, è interessante notare in che modo questi preparativi alla “Cina digitale” porteranno a delle conseguenze anche “esterne” alla Cina, specie per quanto riguarda gli “standard” e la reiterata – e presente anche nel piano per la costruzione di una Cina digitale – richiesta di Xi Jinping di arrivare all’autosufficienza tecnologica per evitare le insidie geopolitiche create dal confronto con gli Stati Uniti.

Proprio per far fronte alle nuove esigenze geopolitiche e reagire in modo più rapido a eventuali oscillazioni rischiose dei rapporti tra Cina e Stati Uniti, alle “due sessioni”, le assemblee legislative che si svolgono una volta all’anno, è stato presentato un piano di riforme “istituzionali” che porteranno alla riorganizzazione del ministero della Scienza e della Tecnologia e alla creazione di un unico ente per la gestione dei dati, responsabile “della promozione dello sviluppo di istituzioni fondamentali relative ai dati, nonché del coordinamento della condivisione e dell’applicazione delle risorse dei dati”. Un ulteriore tassello che va a comporre un vistoso apparato burocratico e normativo con i quali, nell’idea di Xi Jinping, la Cina si appresta ad affrontare il futuro sviluppo digitale del Paese e – allo stesso tempo – le “tempeste” che il Paese dovrà affrontare a livello internazionale per quanto riguarda gli aspetti tecnologici, ormai centrali nei rapporti di forze tra grandi potenze.