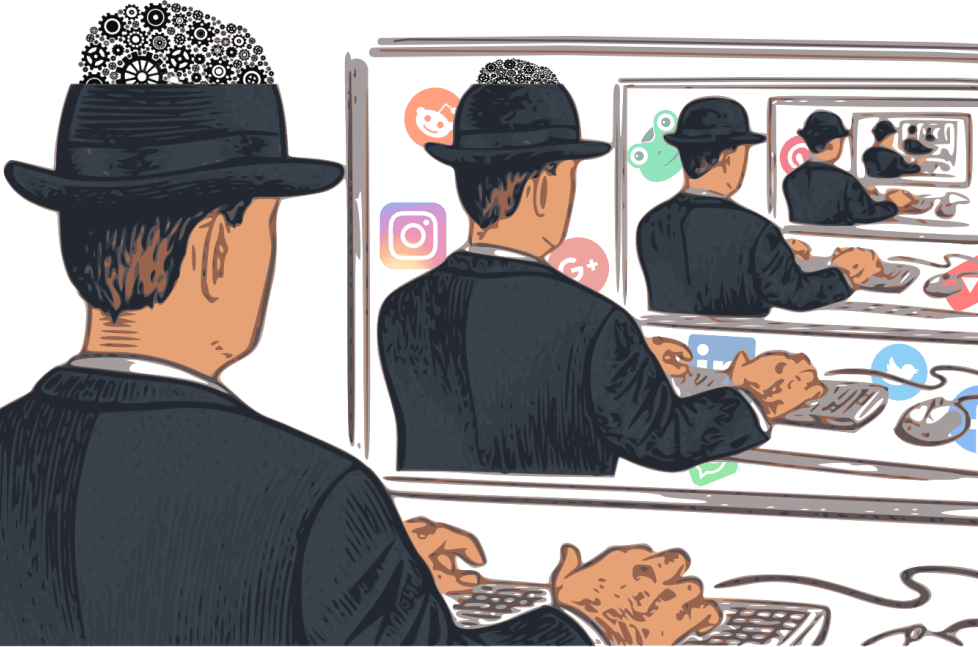

Bufale sul Covid-19, Quattrociocchi: “Ecco i numeri sulla responsabilità dei social”

La diffusione di informazione e disinformazione sul COVID-19 sulle principali piattaforme social a partire dal 3 gennaio 2020 – giorno in cui la Cina ha informato l’OMS della diffusione di una misteriosa polmonite – nelle analisi condotte dal Research Institute for Complexity dell’Università Ca’ Foscari di Venezia